一、简介

- Ollama 是一个开源的可以一键运行大语言模型的工具

- 跨平台支持,也支持在 Docker 容器内快速部署

- 可以运行多种量化模型,让普通电脑流畅运行 LLM 成为可能

- 开源地址参考:https://github.com/ollama/ollama

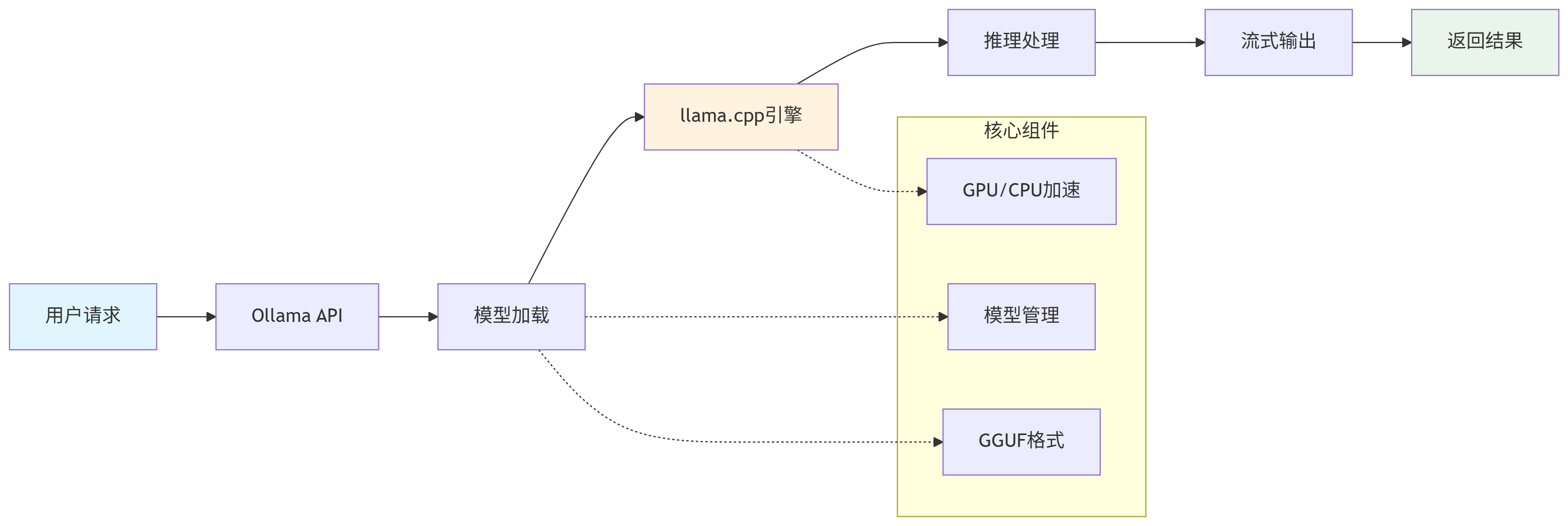

- 核心工作流程参考:

二、安装与下载模型(Docker方式)

1. 使用 docker-compose 安装 Ollama

- 提前安装好Docker、docker-compose软件环境

- (可选)如果有GPU,需要安装好 NVIDIA 驱动程序、NVIDIA Container Toolkit

英伟达驱动安装参考文档: https://developer.nvidia.com/cuda-toolkit-archive

NVIDIA Container Toolkit安装参考文档:https://docs.nvidia.com/datacenter/cloud-native/container-toolkit/latest/install-guide.html

运行下面命令,如果输出显卡信息即Docker内可以正常使用GPUdocker run --rm --gpus all nvidia/cuda:12.5.0-runtime-ubuntu22.04 nvidia-smi - 新建docker-compose.yml配置文件,参考下面内容:

CPU运行版本services: ollama: image: ollama/ollama restart: always volumes: - ./ollama:/root/.ollama #下载的模型及相关配置保存的目录 environment: - OLLAMA_NUM_PARALLEL=2 #最大同时并发响应请求的数量,默认是1 #- OLLAMA_KEEP_ALIVE=-1 #模型加载后多久不用就会自动卸载内存,默认5m(5分钟) #- OLLAMA_MAX_LOADED=2 #最大同时加载的模型数量,默认是1 ports: - "11434:11434"GPU运行版本

services: ollama: image: ollama/ollama restart: always volumes: - ./ollama:/root/.ollama #下载的模型及相关配置保存的目录 environment: - OLLAMA_NUM_PARALLEL=2 #最大同时并发响应请求的数量,默认是1 #- OLLAMA_KEEP_ALIVE=-1 #模型加载后多久不用就会自动卸载内存,默认5m(5分钟) #- OLLAMA_MAX_LOADED=2 #最大同时加载的模型数量,默认是1 ports: - "11434:11434" deploy: #使用GPU主要增加这个配置 resources: reservations: devices: - driver: nvidia count: all #使用所有GPU,可以指定数量和特定GPU capabilities: [gpu] - 配置完,直接一键启动即可

docker-compose up -d

2.下载模型

-

Ollama 可以一键使用的官方模型参考:https://ollama.com/library

-

运行下面命令可以直接下载官方模型镜像

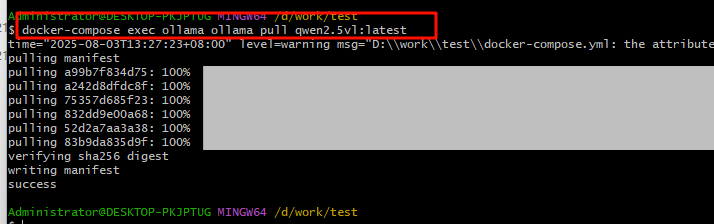

其中qwen2.5vl:latest是通义千问的多模态模型,参考:https://ollama.com/library/qwen2.5vl//运行下面命令,模型会下载到/root/.ollama目录下 docker-compose exec ollama ollama pull qwen2.5vl:latest

-

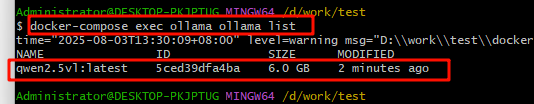

罗列出所有已经下载的模型

docker-compose exec ollama ollama list

三、使用

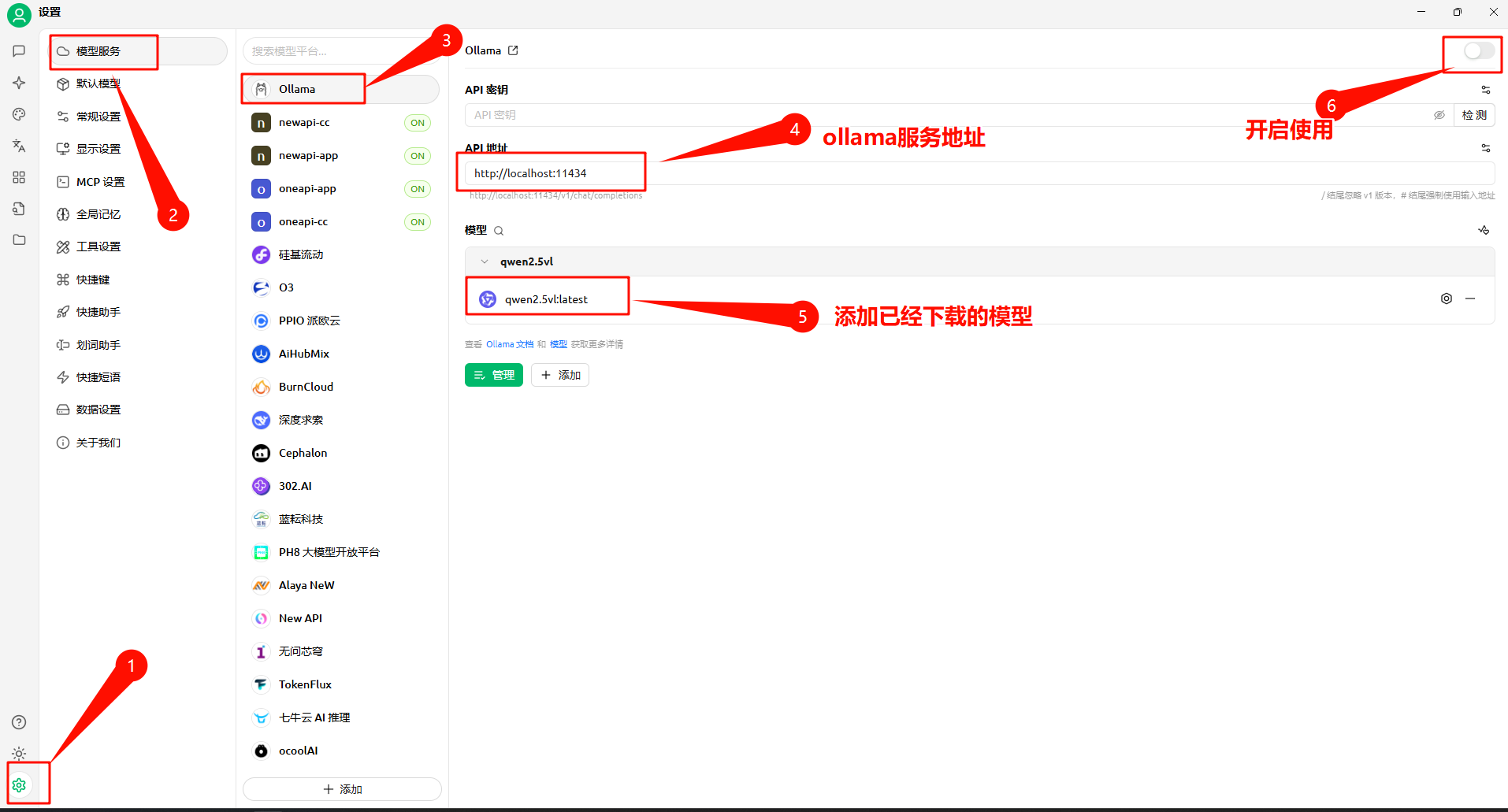

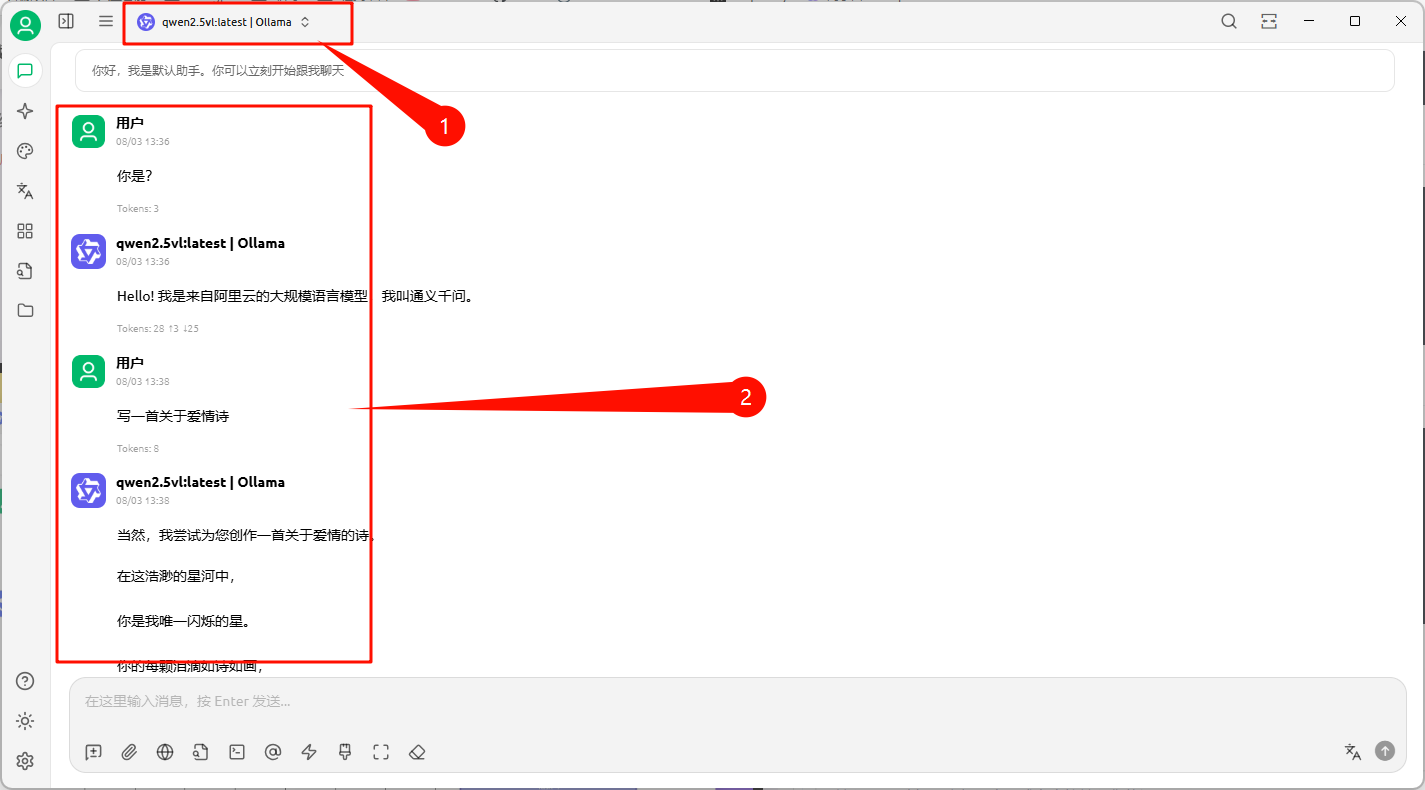

1. 在Cherry Studio大模型对话客户端中使用

-

Cherry Studio安装包下载地址:https://www.cherry-ai.com/

-

配置启动 ollama 模型服务

-

在对话界面,选择本地ollama模型,并进行对话

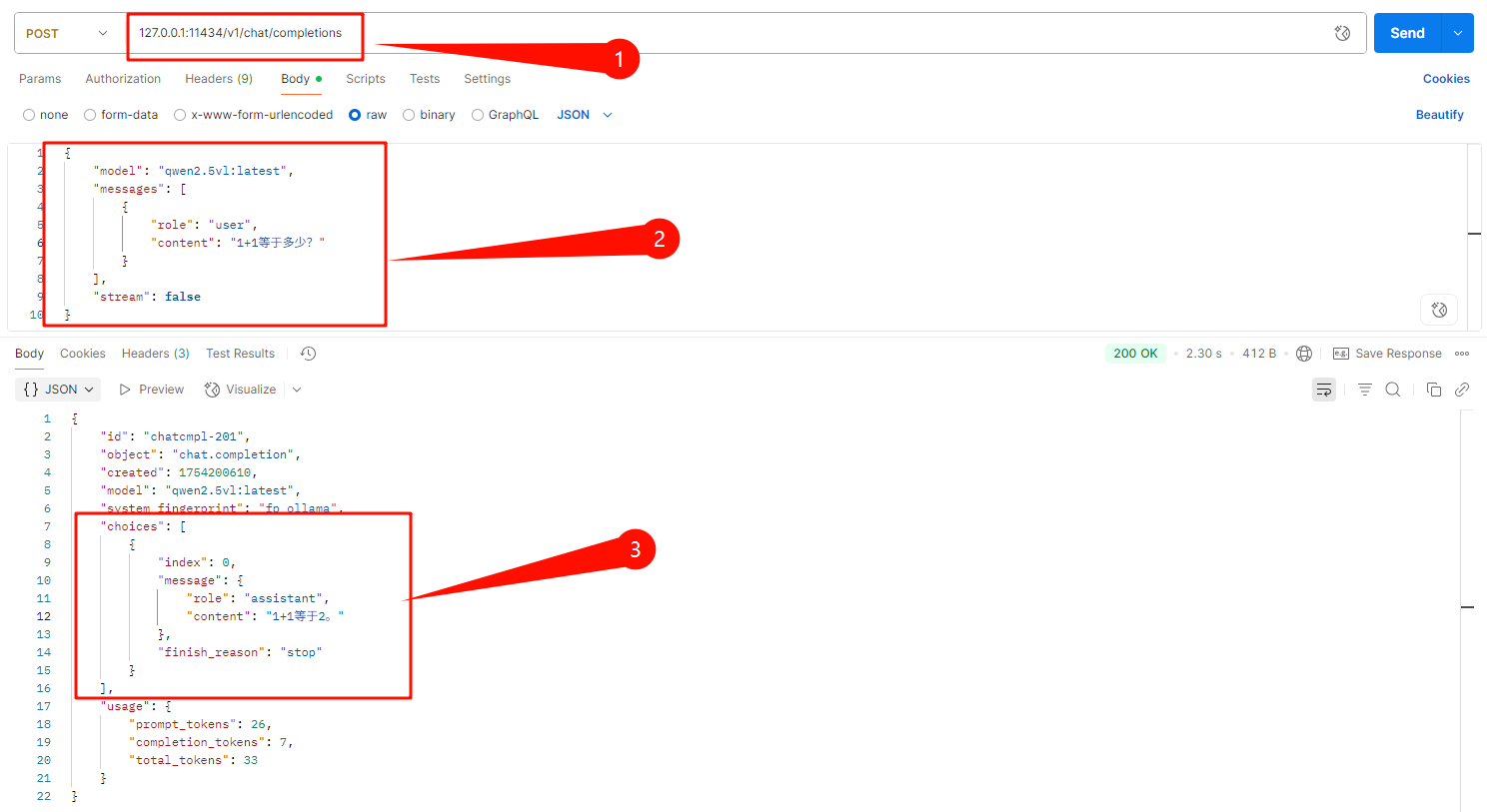

2. 使用 ollama 提供的对话API

-

可以参考官方API文档,地址:https://github.com/ollama/ollama/blob/main/docs/api.md

-

文本对话API,适合通用问题回答

-

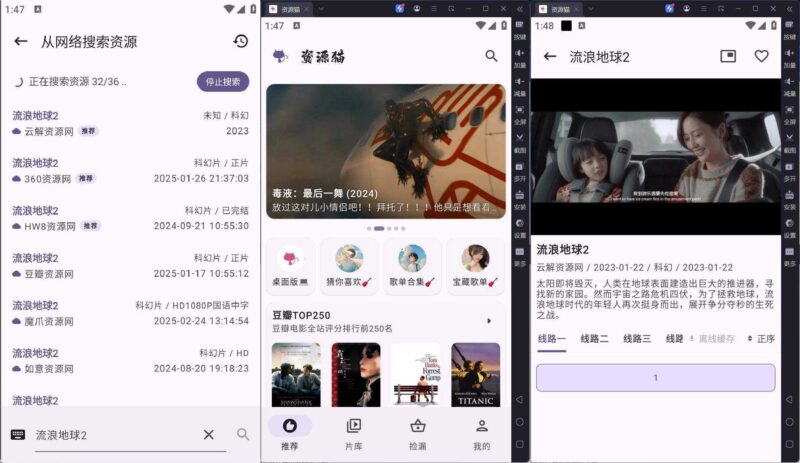

图片对话API,适合OCR,图片描述场景

上面启动的qwen2.5vl:latest是多模态模型,可以进行图片对话,输入下面手写文本图片

![图片[1]-小白友好:用 Ollama 在 Docker 中运行本地 LLM 实战指南-副业网](https://blog.luler.top/assets/files/2025-08-03/1754207224-680488-image.png)

postman请求示例截图如下:

四、总结

- ollama是个非常强大大语言模型启动工具,让普通电脑也能快速运行大语言模型

- 操作使用简单,官方文档齐全,开发者友好,多平台支持,而且模型库更新和社区活跃

- 可以ollama启动本地大模型,询问一下私密问题、搭建本地AI笔记、搭建本地AI数据库应用、识别自己的图片内容

© 版权声明

文章版权归作者所有,未经允许请勿转载。

THE END

暂无评论内容